در دنیای امروز که هوش مصنوعی با سرعتی خیرهکننده در حال نفوذ به همهی صنایع است، زیرساختهای سختافزاری قدرتمند نقشی حیاتی ایفا میکنند. یکی از مهمترین اجزای این زیرساختها، کارت گرافیک مخصوص هوش مصنوعی (AI GPU) است. این کارتها برخلاف مدلهای مصرفی و گیمینگ، برای پردازش موازی سنگین، آموزش مدلهای یادگیری عمیق و اجرای عملیات پیچیده دادهای طراحی شدهاند.

از مراکز داده (Data Center) گرفته تا سرورهای سازمانی، GPUهای هوش مصنوعی در قلب سیستمهای پردازش ابری، آموزش مدلهای زبانی مانند GPT، بینایی ماشین و تحلیلهای پیشرفته قرار گرفتهاند. برندهایی مثل NVIDIA، AMD و اخیراً Intel رقابتی بیوقفه برای عرضه کارتهایی با توان پردازشی خارقالعاده آغاز کردهاند.

در این مقاله، به بررسی جامع این کارتها، تفاوتهایشان با GPUهای سنتی، کاربردهای آنها در زیرساختهای سازمانی و ویژگیهایی که هنگام خرید باید مد نظر داشته باشید میپردازیم. همچنین با معرفی و مقایسه جدیدترین مدلهای کارت گرافیک سرور مناسب AI در سال 2025، مسیر انتخابی هوشمندانهتر را برایتان ترسیم میکنیم.

کارت گرافیک هوش مصنوعی چیست؟

کارت گرافیک هوش مصنوعی (AI GPU) نوعی پردازنده گرافیکی تخصصی است که برای پردازش حجم بسیار بالایی از دادهها بهصورت موازی طراحی شده است. برخلاف کارتهای گرافیکی مصرفی که بیشتر برای بازی یا طراحی گرافیک استفاده میشوند، کارتهای AI برای آموزش مدلهای یادگیری ماشین، اجرای شبکههای عصبی، و انجام محاسبات پیچیده در مقیاس بزرگ به کار میروند.

تفاوتهای اصلی AI GPU با کارتهای گرافیکی معمولی

| ویژگی | GPU معمولی (گیمینگ/مصرفی) | GPU مخصوص هوش مصنوعی (AI GPU) |

|---|---|---|

| نوع حافظه | GDDR6/6X | HBM2e / HBM3 / GDDR6 ECC |

| ظرفیت حافظه | 8–24 گیگابایت | 40–80+ گیگابایت |

| توان پردازشی FP32 | متوسط (10–30 TFLOPS) | بسیار بالا (40–100+ TFLOPS) |

| قابلیت FP16/TF32/INT8 | محدود یا غیرفعال | کاملاً فعال با شتابدهی سختافزاری |

| پشتیبانی از ECC | معمولاً ندارد | بله، برای دقت در محاسبات حیاتی است |

| قابلیت NVLink | ندارد | بله، برای اتصال چند GPU استفاده میشود |

| پشتیبانی نرمافزاری | درایور گرافیکی عمومی | پشتیبانی اختصاصی برای AI/ML و HPC |

| کاربرد اصلی | بازی، طراحی گرافیک | یادگیری عمیق، AI، HPC، تحلیل داده |

کارتهای گرافیکی هوش مصنوعی (AI GPU) برخلاف کارتهای گرافیکی معمولی که عمدتاً برای پردازشهای گرافیکی، بازی و رندرینگ طراحی شدهاند، بهطور اختصاصی برای انجام محاسبات موازی سنگین، آموزش مدلهای یادگیری ماشین و استنتاج در حجم بالا توسعه یافتهاند. این کارتها معمولاً به واحدهای پردازش تنسور (Tensor Cores) مجهز هستند که توانایی انجام محاسبات ماتریسی با دقت بالا را دارند و در نتیجه سرعت آموزش شبکههای عصبی عمیق را بهطور چشمگیری افزایش میدهند. همچنین، حافظه گرافیکی در AI GPUها مانند HBM2 یا HBM3 از نظر پهنای باند و ظرفیت بهمراتب بالاتر از مدلهای معمولی است.

از نظر معماری، AI GPUها از فناوریهایی مانند MIG (Multi-Instance GPU)، NVLink، و NVSwitch پشتیبانی میکنند که امکان تقسیم منابع، مقیاسپذیری بیشتر و ارتباط سریعتر میان کارتها را در محیطهای دیتاسنتر فراهم میسازد. در مقابل، کارتهای گرافیکی معمولی فاقد این قابلیتها هستند و اغلب برای اجرای وظایف سبکتر طراحی شدهاند. به همین دلیل، AI GPUها نهتنها از لحاظ سختافزاری پیشرفتهترند، بلکه از نظر نرمافزار نیز با فریمورکهای یادگیری عمیق مانند TensorFlow و PyTorch بهینهسازی شدهاند تا بهرهوری بیشتری در سناریوهای محاسباتی فراهم کنند.

چرا GPU برای AI مناسبتر از CPU است؟

پردازندههای مرکزی (CPU) برای اجرای تسکهای سریالی طراحی شدهاند، در حالی که GPUها دارای هزاران هستهی پردازشی کوچک هستند که میتونن به صورت همزمان روی دادههای موازی کار کنن. این ساختار باعث میشود GPUها عملکرد فوقالعادهای در آموزش مدلهای یادگیری عمیق، تحلیل تصویر، پردازش زبان طبیعی (NLP) و… داشته باشند.

مثلاً آموزش یک مدل GPT کوچک با CPU ممکن است چند هفته طول بکشد؛ ولی با GPUهای پیشرفته مثل NVIDIA H100 یا A100، همین کار در چند ساعت قابل انجام است.

چه قابلیتهایی در GPUهای AI اهمیت دارند؟

- حافظه حجیم و سریع: برای ذخیره پارامترهای مدلهای بزرگ زبانی یا تصویری.

- پشتیبانی از FP16، BF16، TF32 و INT8: برای اجرای دقیق و سریعتر مدلها.

- شتابدهندههای Tensor Core: مخصوص محاسبات ماتریسی در مدلهای عمیق.

- توان عملیاتی بالا: برای تسکهایی مثل inference همزمان یا آموزش مدلهای چندمیلیارد پارامتری.

- اتصالات پیشرفته مثل NVLink و PCIe Gen5: برای ایجاد خوشههای GPU.

دلایل اهمیت کارت GPU در سرورها

در گذشته، بسیاری از پردازشهای محاسباتی روی CPU انجام میشد؛ اما با افزایش پیچیدگی الگوریتمهای یادگیری ماشین و نیاز به پردازشهای سنگین موازی، کارتهای گرافیکی (GPU) به گزینهای بیرقیب برای اجرای هوش مصنوعی در سرورها تبدیل شدند. در ادامه دلایل اصلی این اهمیت رو بررسی میکنیم:

توان پردازشی فوقالعاده بالا

GPUها دارای هزاران هسته پردازشی هستند که قادرند میلیونها عملیات را به صورت همزمان انجام دهند. این توان پردازشی بهویژه در کاربردهایی مانند آموزش مدلهای بزرگ (مثلاً GPT، BERT، Stable Diffusion و ResNet) کلیدی است.

مدلهایی مثل GPT-4 یا Gemini روی خوشههایی با صدها کارت NVIDIA A100 یا H100 آموزش داده میشوند.

شتابدهی اختصاصی برای مدلهای AI

کارتهای AI دارای بخشهایی به نام Tensor Core (در NVIDIA) یا Matrix Core (در AMD Instinct) هستند که مخصوص اجرای عملیات ماتریسی پیچیده در شبکههای عصبی طراحی شدهاند. این شتابدهندهها در پردازش FP16، BF16 و INT8 عملکردی چند برابر سریعتر از هستههای معمولی دارند.

صرفهجویی در زمان و منابع

با استفاده از GPU، زمان آموزش مدلهای یادگیری عمیق از هفتهها به روزها یا حتی ساعتها کاهش پیدا میکند. این یعنی کاهش مصرف انرژی، زمان کمتر برای بازار رساندن (Time to Market) و بازده بیشتر از زیرساختهای سروری.

مقیاسپذیری بالا برای پروژههای بزرگ

سرورهای GPU با قابلیت اتصال چند کارت (مثلاً تا 8 عدد H100 در یک شاسی) امکان آموزش موازی مدلهای بسیار بزرگ رو فراهم میکنند. اتصالهای پرسرعت مانند NVLink یا PCIe Gen5 اجازه میدهند که دادهها سریع بین کارتها رد و بدل شوند و عملکرد نهایی کاهش پیدا نکند.

پشتیبانی از فریمورکهای AI محبوب

GPUهای هوش مصنوعی بهصورت کامل با فریمورکهایی مثل TensorFlow، PyTorch، Keras، MXNet و JAX سازگارند. پشتیبانی نرمافزاری قوی به توسعهدهندگان کمک میکند که بدون نگرانی از سطح سختافزار، پروژههای خود رو مقیاسپذیر کنند.

پاسخگویی همزمان به چندین درخواست (Inference)

در سرورهایی که بهجای آموزش، فقط مدل رو اجرا میکنند (مثلاً در چتباتها، APIهای بینایی ماشین یا موتورهای پیشنهادگر)، GPU بهخوبی میتواند همزمان به صدها یا هزاران درخواست پاسخ دهد، بدون کاهش محسوس در عملکرد.

انعطافپذیری در استفاده ترکیبی با CPU

کارتهای گرافیک AI معمولاً در کنار پردازندههای قدرتمند (مثل Intel Xeon یا AMD EPYC) استفاده میشوند. این ترکیب باعث میشود که CPU وظایف کنترلی و منطقی رو انجام بده، و GPU بار پردازش سنگین رو به دوش بکشد مدلی که heterogeneous computing نامیده می شود یا محاسبات ناهمگون.

نتیجه: اگر سروری برای کاربردهایی مثل یادگیری عمیق، تحلیل داده، تصویربرداری پزشکی، مدلسازی هواشناسی یا رندرینگ نیاز دارید، کارتهای GPU AI بخش جداییناپذیر از آن خواهند بود.

چرا کارت GPU در سرورها برای هوش مصنوعی اهمیت حیاتی دارد؟

در زیرساختهای مدرن، سرورهایی که به پردازشهای سنگین هوش مصنوعی و یادگیری ماشین اختصاص دارند، بدون GPU عملاً ناکارآمد هستند. کارتهای گرافیک AI نهتنها جایگزینی برای CPU نیستند، بلکه مکملی حیاتی در معماری پردازشهای دادهمحور، ابری و AI محسوب میشوند. در این بخش بهطور کامل دلایل اصلی اهمیت آنها را بررسی میکنیم:

توان پردازشی بیرقیب برای پردازش موازی

در مدلهای یادگیری عمیق (Deep Learning)، بخش عمدهای از عملیات شامل ماتریسهای عظیم و عملیات تکرارشونده است. GPUها با هزاران هسته پردازشی کوچک، میتونن این عملیات رو به صورت موازی و سریعتر از CPU انجام دهند. مدلی مثل ResNet-152 برای پردازش تصاویر در مقیاس انبوه، روی CPU ممکنه چندین ساعت طول بکشد، اما با کارتهایی مثل NVIDIA A100 یا RTX 6000 Ada، این زمان به چند دقیقه کاهش پیدا میکند.

توان عملیاتی FP16 در NVIDIA H100 تا 2000 TFLOPS گزارش شده؛ رقمی بینظیر که حتی نزدیکترین CPU بازار هم بهش نمیرسد.

Tensor Core / Matrix Core | شتابدهندههای تخصصی AI

کارتهای AI فقط به توان خام متکی نیستند. آنها به شتابدهندههای سختافزاری مخصوص هوش مصنوعی مجهزند:

- Tensor Core (در NVIDIA): هستههایی برای اجرای ماتریسهای عظیم در محاسبات FP16، TF32، BF16 یا INT8.

- Matrix Core (در AMD Instinct): قابلیتهای مشابه با بهینهسازی بیشتر برای بار کاری AI.

Tensor Core در یک A100 میتواند هزاران عملیات FP16 در هر سیکل ساعت انجام دهد. در آموزش مدلهای NLP یا Computer Vision این ویژگی نقش کلیدی دارد.

افزایش چشمگیر سرعت آموزش و Inference

مدلهایی مثل GPT-3 یا LLaMA2 شامل میلیاردها پارامتر هستند. آموزش این مدلها به GPU نیاز داره، چون CPU اصلاً توانایی هندل کردن این حجم از داده موازی رو ندارد.

| مدل LLM | پارامترها (تقریبی) | آموزش روی CPU (تخمینی) | آموزش روی GPU A100 (تقریبی) |

|---|---|---|---|

| GPT-2 Large | 774 میلیون | ۳۵۰ ساعت | ۸ ساعت |

| GPT-3 (175B) | ۱۷۵ میلیارد | غیرممکن (ماهها) | چند هفته روی چندصد GPU |

| LLaMA 2 - 13B | ۱۳ میلیارد | ۵۰۰+ ساعت | ۲۴–۴۸ ساعت |

این تفاوت باعث صرفهجویی چند صد میلیون تومانی در زمان، انرژی، و هزینه نیروی انسانی میشود.

پاسخگویی همزمان به هزاران کاربر (inference مقیاسپذیر)

وقتی مدل آموزش داده شده و آماده ارائه خدماته (مثلاً موتور پیشنهاددهنده، ترجمه آنی، تشخیص چهره یا چتبات)، GPU میتواند بهصورت آنی به صدها یا حتی هزاران کاربر پاسخ دهد. سرویسهای Cloud AI مثل Google Colab یا HuggingFace inference endpoint از سرورهایی با چندین کارت A100 برای پاسخگویی بلادرنگ استفاده میکنند.

پشتیبانی از معماری چند GPU و شبکه GPUها

کارتهای AI برای اتصال بهصورت خوشهای (Clustered GPU) طراحی شدند. تکنولوژیهایی مثل:

- NVIDIA NVLink / NVSwitch

- AMD Infinity Fabric

- PCIe Gen4/Gen5

به این کارتها اجازه میدهد که با پهنای باند بالا (تا 900 گیگابایت بر ثانیه) به هم وصل شوند و مثل یک GPU عظیم عمل کنند.

با این ساختار، امکان آموزش مدلهای چندصدهزار پارامتری یا multi-node فراهم میشود.

پشتیبانی نرمافزاری قوی و پایدار

NVIDIA با CUDA و cuDNN و AMD با ROCm پلتفرمهایی ارائه دادن که توسعهدهندهها بتوانند به راحتی از تمام قدرت کارتها بهرهمند شوند.

PyTorch، TensorFlow، JAX و MXNet با GPU سازگارند.

ابزارهایی مثل NVIDIA Triton یا AMD MIG inference server برای deployment بلادرنگ استفاده میشوند.

کاربردهای فراتر از AI

کارتهای GPU AI در مواردی مثل:

- تحلیل Big Data

- شبیهسازیهای علمی (computational physics)

- تصویربرداری پزشکی (MRI، CT scan)

- طراحی صنعتی (CAD/CAE)

- رندرینگ انیمیشن و VFX

هم استفاده میشوند، یعنی فقط محدود به AI نیستند. کارتهای گرافیکی AI بهواسطه توان پردازشی خارقالعاده، شتابدهندههای تخصصی، پشتیبانی نرمافزاری کامل و قابلیت اتصال خوشهای، به ستون فقرات سرورهای AI محور تبدیل شدهاند. چه در مراکز داده بزرگ، چه در شرکتهای تحقیقاتی یا حتی در کسبوکارهای متوسط، این کارتها نقشی حیاتی دارند.

بیشتر بخوانید <<>> سرور هوش مصنوعی

معرفی و مقایسه بهترین کارتهای گرافیک هوش مصنوعی در سال ۲۰۲۵

در سالهای اخیر، شرکتهای بزرگی مانند NVIDIA و AMD رقابتی جدی را در زمینه طراحی و عرضه کارتهای گرافیک مخصوص هوش مصنوعی آغاز کردهاند. این کارتها با هدف پشتیبانی از آموزش و اجرای مدلهای پیچیده یادگیری ماشین، طراحی شده و در زیرساختهای پردازشی مدرن جایگاهی کلیدی پیدا کردهاند.

در این بخش، به بررسی و مقایسه تخصصی مهمترین کارتهای گرافیک هوش مصنوعی در سال ۲۰۲۵ پرداخته میشود تا انتخاب صحیحتری برای کاربردهای سازمانی و سروری صورت گیرد.

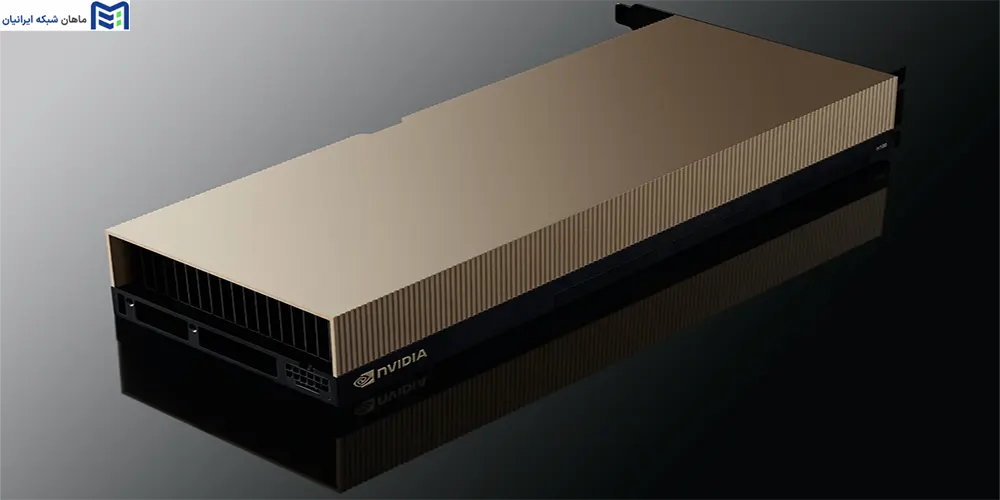

NVIDIA H100 Tensor Core GPU (گزینه شماره یک برای پروژههای هوش مصنوعی در مقیاس کلان)

- حافظه: ۸۰ گیگابایت HBM3e

- پهنای باند حافظه: تا ۳.۲ ترابایت بر ثانیه

- توان پردازشی (FP16): بیش از ۲٬۰۰۰ ترافلاپس

- توان مصرفی (TDP): حدود ۷۰۰ وات

- موارد مصرف: آموزش مدلهای زبان بزرگ (LLM)، مدلسازی پیشرفته، inference در مقیاس بالا

- ویژگی متمایز: پشتیبانی از Transformer Engine برای افزایش سرعت آموزش مدلهای NLP

کارت گرافیک NVIDIA H100 بر پایه معماری Hopper، پیشرفتهترین راهکار برای آموزش مدلهای زبان بزرگ (LLMs) و شبکههای عصبی عمیق در مراکز داده است. این کارت برای پروژههایی طراحی شده که به بیشترین توان پردازشی نیاز دارند، مانند آموزش مدلهایی با صدها میلیارد پارامتر (مانند GPT-4، Gemini، Claude و LLaMA 3). توان پردازشی بسیار بالا در کنار حافظه HBM3e با پهنای باند فوقالعاده، H100 را به گزینهای ایدهآل برای پردازش موازی گسترده تبدیل کرده است.

در محیطهای مبتنی بر HPC (محاسبات با کارایی بالا)، مراکز تحقیقاتی، ارائهدهندگان سرویسهای ابری و شرکتهای تولیدکننده مدلهای مولد زبان، H100 قابلیت اتصال در شبکههای NVLink و استفاده در ساختارهای multi-GPU را فراهم میکند. این ویژگیها باعث میشود که آموزش مدلهای بزرگ با دقت بالا و زمان کمتر قابل اجرا باشد و inference نیز در مقیاس انبوه، با کمترین تأخیر انجام شود.

NVIDIA A100 (انتخاب متعادل برای آموزش و inference در سازمانها)

- حافظه: ۴۰ یا ۸۰ گیگابایت HBM2e

- پهنای باند حافظه: تا ۲ ترابایت بر ثانیه

- توان پردازشی (FP16): حدود ۳۱۲ ترافلاپس

- توان مصرفی: ۴۰۰ تا ۵۰۰ وات

- موارد مصرف: آموزش مدلهای متوسط تا بزرگ، اجرای inference موازی

- ویژگی متمایز: پشتیبانی کامل از multi-instance GPU (MIG) برای تخصیص بهینه منابع به وظایف مختلف

A100 یکی از محبوبترین کارتهای گرافیک AI در مراکز داده طی چند سال اخیر بوده است. این کارت بهویژه در سرورهایی که برای آموزش مدلهای NLP، بینایی ماشین، تحلیل رفتار کاربر و تشخیص خودکار طراحی شدهاند، بسیار کاربردی است. کارت گرافیک انویدیا A100 با پشتیبانی از حافظه HBM2e و معماری Ampere، برای مدلهایی با اندازه متوسط تا بزرگ بسیار مناسب است؛ بهویژه وقتی منابع سختافزاری محدود است اما عملکرد بالا مورد انتظار است.

در محیطهای سازمانی که نیاز به تقسیمبندی GPU برای اجرای همزمان چند پروژه یا تیم تحقیقاتی وجود دارد، ویژگی Multi-Instance GPU (MIG) در A100 بسیار کاربردی است. این قابلیت امکان تخصیص کارت به چند زیرسیستم را بدون تداخل عملکرد فراهم میکند. در سناریوهایی مانند inference API، تحلیل تصویر پزشکی یا سیستمهای امنیتی مبتنی بر بینایی ماشین، A100 ترکیبی عالی از قدرت، انعطافپذیری و مصرف بهینه انرژی را ارائه میدهد.

NVIDIA RTX 6000 Ada (مناسب برای inference سریع و محیطهای تولیدی بلادرنگ)

- حافظه: ۴۸ گیگابایت GDDR6 ECC

- پهنای باند حافظه: حدود ۹۶۰ گیگابایت بر ثانیه

- توان پردازشی (FP32): حدود ۹۰ ترافلاپس

- توان مصرفی: حدود ۳۰۰ وات

- موارد مصرف: inference بلادرنگ، پردازش تصویر، استفاده در ورکاستیشنهای مهندسی

- ویژگی متمایز: بهرهگیری از نسل جدید معماری Ada برای بهینهسازی مصرف انرژی و افزایش سرعت پردازش

کارت RTX 6000 Ada نسل جدیدی از GPUهای حرفهای NVIDIA است که برای استفاده در ایستگاههای کاری (Workstation) و سرورهایی که inference سریع و دقیق نیاز دارند، طراحی شده است. این کارت در پروژههایی که مدلهای از پیش آموزشدیده باید با تأخیر حداقلی به درخواستهای کاربران پاسخ دهند، بسیار کاربردی است؛ از جمله موتورهای جستوجوی هوشمند، چتباتها، سیستمهای تشخیص چهره یا تحلیل ویدیویی بلادرنگ.

علاوه بر این، در بسیاری از شرکتهای صنعتی، معماری، پزشکی و خودروسازی که به رندرینگ پیشرفته، شبیهسازی و طراحی مهندسی وابستهاند، RTX 6000 Ada با بهرهگیری از حافظه ECC و پردازندههای نسل Ada، عملکرد پایدار و دقیق ارائه میدهد. اگرچه این کارت توان رقابتی با H100 در آموزش مدلهای غولپیکر را ندارد، اما در فاز اجرا (inference) و کاربردهای عملیاتی روزمره، یکی از بهترین گزینهها بهشمار میآید.

AMD Instinct MI300X / MI350 (راهکار رقیب برای هوش مصنوعی در مقیاس بالا)

- حافظه: ۱۹۲ تا ۲۸۸ گیگابایت HBM3

- پهنای باند حافظه: تا ۵.۳ ترابایت بر ثانیه

- توان پردازشی (FP16): تخمینی بیش از ۱٬۲۰۰ ترافلاپس

- توان مصرفی: ۵۰۰ تا ۶۰۰ وات

- موارد مصرف: آموزش مدلهای بسیار حجیم، محاسبات علمی و پردازشهای سنگین دیتا

- ویژگی متمایز: بهرهمندی از معماری CDNA 3 و قابلیت اتصال به دیگر GPUها از طریق Infinity Fabric

کارتهای گرافیک AMD Instinct MI300X و MI350 بهعنوان رقیب مستقیم سری NVIDIA H100، برای کاربردهای کلان در مراکز HPC و AI طراحی شدهاند. حافظه عظیم تا ۲۸۸ گیگابایت HBM3 در کنار پهنای باند بسیار بالا، این GPU را برای آموزش مدلهای بزرگ و محاسبات دقیق علمی مناسب کرده است. در سازمانهایی که به مدلهای ترکیبی AI + شبیهسازی علمی (مانند هواشناسی، فیزیک کوانتوم، یا تصویربرداری پزشکی با رزولوشن بالا) نیاز دارند، MI300X گزینهای قدرتمند است.

از آنجایی که AMD در سالهای اخیر بستر نرمافزاری ROCm را توسعه داده، پشتیبانی از PyTorch و TensorFlow در این کارتها نیز تقویت شده است. همچنین، MI300X با اتصال از طریق Infinity Fabric، قابلیت توسعه خوشههای GPU را دارد. استفاده از آن در سرورهای اختصاصی برای AI در شرکتهای مخابراتی، انرژی، خودروسازی و دفاعی، بهویژه در کشورهایی که بهدنبال جایگزین غیر-NVIDIA هستند، رو به افزایش است.

NVIDIA RTX 4090 (گزینهای اقتصادی برای توسعه و تست مدلهای AI در ابعاد کوچکتر)

- حافظه: ۲۴ گیگابایت GDDR6X

- پهنای باند حافظه: ۱٬۰۰۸ گیگابایت بر ثانیه

- توان پردازشی (FP16): حدود ۸۳۵ ترافلاپس (با Tensor Core)

- توان مصرفی: حدود ۴۵۰ وات

- موارد مصرف: توسعه اولیه مدلهای یادگیری ماشین، inference نیمهحرفهای

- ویژگی متمایز: در دسترس بودن، هزینه پایینتر نسبت به کارتهای دیتاسنتر، اما فاقد ECC و قابلیتهای دیتاسنتر

اگرچه RTX 4090 کارت گرافیکی مصرفی بهشمار میآید و مخصوص دیتاسنتر طراحی نشده است، اما توان بالای آن در اجرای عملیات AI موجب شده که در بسیاری از پروژههای تحقیقاتی، دانشگاهی و حتی سازمانهای کوچک بهکار گرفته شود. این کارت برای آموزش مدلهای یادگیری عمیق در ابعاد کوچک یا متوسط (مانند image classification یا chatbotهای ساده)، بسیار مناسب است. در مواردی که بودجه محدود باشد یا فضای رک برای نصب کارتهای حرفهای دیتاسنتری وجود نداشته باشد، RTX 4090 انتخابی اقتصادی محسوب میشود. با وجود توان پردازشی بالا، این کارت فاقد ویژگیهایی مانند حافظه ECC، قابلیت NVLink و معماری اختصاصی Multi-Instance است؛ به همین دلیل توصیه میشود بیشتر برای توسعه، آزمایش و تست مدلها مورد استفاده قرار گیرد، نه برای محیطهای عملیاتی حساس یا mission-critical.

جدول مقایسه تخصصی کارتهای AI در سال ۲۰۲۵

| مدل کارت | حافظه | نوع حافظه | پهنای باند | توان FP16 | توان مصرفی | مناسب برای |

|---|---|---|---|---|---|---|

| NVIDIA H100 | 80GB | HBM3e | 3.2 TB/s | 2000+ TF | ~700W | آموزش LLM، AI در مقیاس کلان |

| NVIDIA A100 | 40/80GB | HBM2e | 2.0 TB/s | ~312 TF | ~500W | آموزش مدلهای بزرگ، inference |

| RTX 6000 Ada | 48GB | GDDR6 ECC | 960 GB/s | ~90 TF | ~300W | inference سریع، ورکاستیشن |

| AMD MI300X/350 | 192–288GB | HBM3 | 5.3 TB/s | ~1200 TF | ~600W | پردازش علمی، مدلهای عظیم |

| RTX 4090 | 24GB | GDDR6X | 1.0 TB/s | ~835 TF | ~450W | توسعه آزمایشی، پروژههای سبکتر |

معماری شبکهبندی GPU در سرورهای پیشرفته: NVLink، خوشههای چند GPU و اهمیت مقیاسپذیری

در پروژههای هوش مصنوعی بزرگ، بهویژه هنگام آموزش مدلهایی با میلیاردها پارامتر، استفاده از یک GPU بهتنهایی پاسخگو نیست. در چنین سناریوهایی، نیاز به اتصال چندین کارت گرافیک بهصورت موازی مطرح میشود تا پردازش توزیعشده (Distributed Training) ممکن شود. اینجاست که مفهوم معماریهای ارتباطی مانند NVLink و NVSwitch در سرورهای GPU-محور اهمیت مییابد.

فناوری NVLink و NVSwitch در کارتهای NVIDIA

NVLink فناوری اختصاصی NVIDIA برای ارتباط پرسرعت بین چند GPU است که پهنای باندی بهمراتب بالاتر از PCIe فراهم میکند. در کارتهایی مانند H100 یا A100، این فناوری اجازه میدهد که چندین GPU بدون ایجاد گلوگاه در انتقال داده، بهصورت مستقیم با یکدیگر ارتباط برقرار کنند. در ساختارهای بزرگتر، NVIDIA از NVSwitch استفاده میکند که مانند یک هاب مرکزی عمل کرده و امکان ارتباط کامل بین تمام GPUهای موجود در یک نود را فراهم میسازد.

این معماری برای آموزش مدلهای GPT، BERT، DALL-E و سایر شبکههای عظیم ضروری است. چرا که آموزش چنین مدلهایی نیازمند بهاشتراکگذاری سریع پارامترها، گرادیانها و دادههای میانی بین کارتهای مختلف در طول هر iteration است.

ساختارهای Multi-GPU و خوشههای محاسباتی (GPU Clusters)

در سطوح بالاتر، معماریهای Multi-GPU در سرورهایی با ۴، ۸ یا حتی ۱۶ کارت گرافیک پیادهسازی میشوند. شرکتهایی مانند NVIDIA با معرفی DGX H100 یا HGX A100 ساختارهایی آماده برای این نوع پردازش فراهم کردهاند که در آنها کارتها از طریق NVSwitch بهطور کامل به یکدیگر متصل شدهاند. همچنین بسیاری از مراکز داده، چند نود GPU را بهصورت خوشهای (cluster) از طریق شبکههای پرسرعت مانند InfiniBand به هم متصل میکنند تا مقیاسپذیری بیشتری به دست آید.

در محیطهای ابری مانند AWS، Google Cloud یا Azure نیز این نوع خوشهسازی فراهم شده است و کاربران میتوانند بهصورت اجارهای از دهها یا صدها کارت گرافیک در یک پروژه AI استفاده کنند. طراحی نرمافزاری برای استفاده بهینه از چنین معماریهایی معمولاً به کمک چارچوبهایی نظیر NVIDIA NCCL، Horovod، DeepSpeed یا PyTorch Distributed انجام میشود.

بیشتر بخوانید <<>> جدیدترین هوش مصنوعی رایگان

تفاوت کارت گرافیک AI با کارتهای گرافیک گیمینگ و ورکاستیشن

با رشد استفاده از هوش مصنوعی در کسبوکارها، بسیاری از کاربران تفاوت بین کارتهای گرافیک مخصوص AI با مدلهای گیمینگ یا ورکاستیشن را بهدرستی نمیدانند. اگرچه ممکن است برخی مشخصات فنی (مانند تعداد هستهها یا مقدار حافظه) شبیه بهنظر برسد، اما طراحی، کاربرد و قابلیتهای اصلی این سه نوع کارت تفاوتهای بنیادینی دارند.

کارتهای گرافیک گیمینگ (مانند RTX 4090 و RTX 4080)

کارتهای گیمینگ برای اجرای بازیها با گرافیک سنگین، پشتیبانی از ray tracing، و نرخ فریم بالا در رزولوشنهای بالا طراحی شدهاند. معماری آنها (مانند Ada یا Ampere) توان پردازشی بالایی دارد، اما فاقد ویژگیهایی است که برای استفاده مداوم در دیتاسنتر ضروری است. این کارتها معمولاً از نظر کنترل حرارت، پایداری در بار کاری دائم، و امکانات مانیتورینگ در سطح صنعتی طراحی نشدهاند.

در بسیاری از موارد، کارتهای گیمینگ فاقد حافظه ECC (تشخیص و تصحیح خطا)، قابلیت اتصال از طریق NVLink، پشتیبانی از چند GPU در ساختارهای کلان، یا تضمین عملکرد پایدار در بار کاری 24/7 هستند. به همین دلیل، استفاده از آنها در سرور تنها برای تست یا پروژههای آزمایشی با ریسک پایین پیشنهاد میشود.

کارتهای ورکاستیشن (مانند RTX 6000 Ada و A6000)

این دسته از کارتها برای محیطهای حرفهای مانند رندرینگ سهبعدی، طراحی مهندسی، مدلسازی پزشکی، شبیهسازی و ویرایش ویدئوهای سنگین طراحی شدهاند. معمولاً مجهز به حافظه ECC، درایورهای اختصاصی حرفهای (NVIDIA Studio یا Enterprise)، مصرف برق پایدار، و طراحی حرارتی بهینه هستند. با اینکه این کارتها از توان پردازش مناسبی برای اجرای مدلهای هوش مصنوعی نیز برخوردارند، اما معمولاً فاقد قابلیتهایی مانند MIG (Multi-Instance GPU) یا اتصال NVLink در سطح گسترده هستند.

در سازمانهایی که همزمان به رندرینگ و AI سبک نیاز دارند (مثلاً در طراحی خودرو با بینایی ماشین یا معماری با شبیهسازی نوری)، این کارتها میتوانند تعادل خوبی ایجاد کنند.

کارتهای گرافیک هوش مصنوعی (مانند A100، H100، MI300X)

این کارتها بهطور اختصاصی برای AI Training و Inference طراحی شدهاند. پشتیبانی از حافظه HBM2/3، فناوریهای ارتباطی پیشرفته مانند NVLink و NVSwitch، قابلیت تقسیم GPU به زیرسیستمها (MIG)، مقاومت حرارتی بالا، و طراحی خاص برای محیطهای Rackmount باعث شده که این کارتها گزینه اول دیتاسنترها و زیرساختهای cloud-native باشند. همچنین، درایورهای آنها برای چارچوبهای یادگیری ماشین بهینه شدهاند و اغلب از پلتفرمهای نرمافزاری مانند NVIDIA AI Enterprise یا ROCm (برای AMD) بهره میبرند.

در پروژههایی با مقیاس بالا، مانند آموزش مدلهای مولد، سیستمهای تشخیص پزشکی بلادرنگ، بینایی ماشین صنعتی، تحلیل تصویر ماهوارهای و سامانههای تشخیص تهدید سایبری، این دسته از کارتها تنها گزینه مناسب هستند.

چالشها و معیارهای انتخاب کارت گرافیک مناسب برای سرورهای AI

انتخاب یک کارت گرافیک برای اجرای هوش مصنوعی در محیط سروری، فقط بر پایه قدرت پردازشی خام یا ظرفیت حافظه نیست. فاکتورهای متعددی وجود دارد که در صورت بیتوجهی به آنها، میتواند منجر به اتلاف منابع، ناسازگاری با زیرساخت و حتی توقف پروژه شود. در ادامه، به مهمترین معیارهای فنی و اجرایی برای انتخاب کارت گرافیک مناسب پرداختهایم:

نوع بارکاری (Training یا Inference)

ابتدا باید مشخص شود که کارت گرافیک برای آموزش مدلهای بزرگ (Training) استفاده خواهد شد یا برای اجرای آنها در محیط عملیاتی (Inference). کارتهایی مانند NVIDIA H100، MI300X یا A100 برای Training طراحی شدهاند و دارای حافظه بالا، هستههای Tensor متعدد و قابلیت اتصال به شبکههای NVLink هستند. در مقابل، کارتهایی مانند L40S یا L4 برای استقرار مدلهای آموزشدیده در مقیاس بالا مناسبترند.

پشتیبانی نرمافزاری و Framework Compatibility

اطمینان از پشتیبانی کارت موردنظر از فریمورکهایی مانند TensorFlow، PyTorch، ONNX Runtime و سایر کتابخانههای AI، بسیار حیاتی است. NVIDIA از اکوسیستم بالغتری برخوردار است و پلتفرمهای CUDA، cuDNN و TensorRT آن تقریباً با همه ابزارهای توسعه هماهنگاند. در حالی که AMD با پلتفرم ROCm هنوز در حال توسعه زیرساخت نرمافزاری خود است، اگرچه پیشرفتهای قابل توجهی داشته است.

توان حرارتی (TDP) و سازگاری با زیرساخت

کارتهای AI حرفهای ممکن است توان حرارتی بالایی داشته باشند (مثلاً H100 با 700 وات TDP). بنابراین باید بررسی کرد که سرور یا شاسی مدنظر از نظر پاور، تهویه و چیدمان فیزیکی (Form Factor) امکان پشتیبانی از آن را دارد یا نه. همچنین سازگاری با اسلاتهای PCIe یا پشتیبانی از اتصالهای NVLink باید بررسی شود.

حجم حافظه و نوع حافظه (GDDR6، HBM2e، HBM3)

حجم حافظه در مدلهای زبانی بزرگ، پردازش تصویر با رزولوشن بالا یا شبکههای عمیق حیاتی است. بهطور مثال، مدلهای GPT برای آموزش یا Fine-Tuning، حداقل به 40 الی 80 گیگابایت حافظه نیاز دارند. حافظه HBM3 نهتنها پهنای باند بالاتری نسبت به GDDR6 فراهم میکند، بلکه تأخیر پایینتری نیز دارد و برای مدلهای عظیم یا inference همزمان مناسبتر است.

مقیاسپذیری و پشتیبانی از چند GPU

در پروژههایی که نیاز به آموزش توزیعشده (Distributed Training) دارند، قابلیت اتصال چند کارت از طریق NVLink یا پشتیبانی از معماریهای HGX/DGX اهمیت حیاتی دارد. باید بررسی کرد که آیا کارت گرافیک انتخابی با نرمافزارهای مثل Horovod، NCCL، یا PyTorch DDP سازگار است یا خیر.

هزینه کل مالکیت (TCO) و طول عمر محصول

در کنار قیمت اولیه کارت، باید هزینههای بلندمدت مانند مصرف برق، خنکسازی، نگهداری، پشتیبانی فنی و دسترسپذیری قطعات یدکی را هم در نظر گرفت. برخی کارتها با داشتن پشتیبانی بلندمدت نرمافزاری، کاهش خرابی سختافزاری و ارائه ابزارهای مانیتورینگ اختصاصی (مانند NVIDIA DCGM) باعث بهبود TCO در محیطهای سازمانی میشوند.

در دسترس بودن در بازار و پشتیبانی گارانتی

در پروژههای حساس، زمان تأمین تجهیزات بسیار مهم است. باید بررسی شود که کارت موردنظر در بازار ایران یا منطقه قابل تهیه است، همراه با گارانتی معتبر، و تیم فنی ارائهدهنده آن پشتیبانی مناسبی دارد. تیمهایی مانند “ماهان شبکه ایرانیان” با تجربه در تأمین کارتهای AI، در این حوزه میتوانند مشاوره تخصصی ارائه دهند..

چه سرورهایی از این کارتهای GPU برای هوش مصنوعی پشتیبانی میکنند؟

در ادامه، به معرفی سرورهای رایج و حرفهای که از کارتهای NVIDIA A100، H100 و RTX 6000 Ada پشتیبانی میکنند، میپردازیم. این سرورها معمولاً در دیتاسنترها و مراکز دادهی پیشرفته استفاده میشوند و سازگاری سختافزاری و نرمافزاری لازم را برای بهرهبرداری کامل از کارتهای هوش مصنوعی فراهم میکنند.

| سرور HPE | مشخصات کلیدی | کارتهای گرافیک قابل پشتیبانی | کاربردها و نکات مهم |

|---|---|---|---|

| HPE Apollo 6500 Gen10 Plus | - پشتیبانی تا 8 کارت NVIDIA A100 SXM- توان حرارتی تا 400 وات برای هر کارت- طراحی مخصوص محاسبات موازی در AI- خنککننده پیشرفته و منبع تغذیه قدرتمند | NVIDIA A100 (SXM و PCIe) | مناسب برای آموزش مدلهای AI بزرگ و محاسبات موازی گسترده در مراکز داده حرفهای و مراکز هوش مصنوعی. |

| HPE Apollo 6500 Gen11 | - پشتیبانی کارتهای NVIDIA H100 SXM- توان حرارتی بالا (حدود 700 وات)- پشتیبانی از NVSwitch و MIG- طراحی بهینه برای مدلهای مولد AI | NVIDIA H100 (SXM) | مناسب پروژههای پیشرفته مولد AI و آموزش مدلهای بسیار بزرگ و سنگین در دیتاسنترهای نسل جدید. |

| HPE ProLiant DL380 Gen10 Plus | - سرور رکمونت 2U- پشتیبانی از کارتهای PCIe تا توان حرارتی 300 وات- انعطافپذیر و قابل توسعه برای سازمانها و مراکز داده متوسط | NVIDIA RTX 6000 Ada (PCIe) | مناسب ورکلودهای ترکیبی شامل رندرینگ حرفهای، AI سبک و پردازشهای گرافیکی سازمانی. |

| HPE ProLiant DL325 Gen10 Plus | - سرور تکپردازندهای فشرده- پشتیبانی از کارتهای PCIe نسل 4- طراحی کممصرف و مقرون به صرفه | NVIDIA RTX 6000 Ada (PCIe) | گزینهای مناسب برای سازمانهایی با نیاز AI سبک و پردازش گرافیکی متوسط با مصرف انرژی کمتر. |

| HPE ProLiant DL380 Gen11 | - پشتیبانی از PCIe Gen5- نصب همزمان چند کارت گرافیک پرتوان- خنککننده پیشرفته و منبع تغذیه قدرتمند- پشتیبانی از NVLink و MIG در کارتهای SXM | NVIDIA A100 (PCIe/SXM)، NVIDIA H100 (SXM)، NVIDIA RTX 6000 Ada (PCIe) | سرور همهکاره و مدرن برای پردازشهای AI سنگین، یادگیری ماشین، دیتاسنترهای ابری و پردازشهای گرافیکی پیشرفته. |

NVIDIA A100 (SXM و PCIe)

کارت گرافیک NVIDIA A100 با معماری Ampere و حافظه HBM2e یکی از قدرتمندترین گزینهها برای آموزش و استنتاج مدلهای هوش مصنوعی در دیتاسنترها محسوب میشود. این کارت با توان محاسباتی بالا، پهنای باند حافظه وسیع و پشتیبانی از فناوری MIG امکان تقسیم منابع و اجرای چندین پردازش به صورت همزمان را فراهم میکند. سرورهای HPE سری Apollo 6500 Gen10 Plus و Gen11 به خوبی از این کارت پشتیبانی کرده و امکاناتی مثل NVLink را برای اتصال سریع بین کارتها در اختیار کاربران قرار میدهند.

کاربرد اصلی A100 در پروژههای محاسباتی بسیار سنگین است که نیاز به مقیاسپذیری، توان بالای پردازشی و مدیریت هوشمند منابع دارند. این کارت در حوزههایی مانند بینایی ماشین، یادگیری عمیق، تحلیل دادههای حجیم و مدلهای زبان بزرگ (Large Language Models) کاربرد دارد و برای سازمانهایی که به دنبال بهرهوری بالاتر در محیطهای محاسباتی هستند، انتخاب ایدهآلی به شمار میرود.

NVIDIA H100 (SXM)

کارت گرافیک NVIDIA H100 با معماری Hopper و حافظه HBM3، جدیدترین نسل کارتهای NVIDIA برای هوش مصنوعی است که توان پردازشی فوقالعادهای ارائه میدهد. با پشتیبانی از فناوری FP8 و NVSwitch، این کارت به خصوص برای آموزش مدلهای مولد پیشرفته، مانند مدلهای GPT و ترنسفورمرهای بزرگ، طراحی شده است. HPE Apollo 6500 Gen11 با طراحی اختصاصی خود، امکان بهرهبرداری کامل از این کارت را با مدیریت توان حرارتی بسیار بالا و اتصالات NVLink فراهم میکند.

کاربردهای H100 در پروژههای مولد AI، پردازشهای سنگین و استنتاج در مقیاس بزرگ است. این کارت برای دیتاسنترهای پیشرفته و سازمانهایی که نیاز به قدرت محاسباتی بینظیر دارند، بهترین گزینه به شمار میآید و کمک میکند تا کارایی مدلهای هوش مصنوعی با سرعت و دقت بیشتری ارتقا یابد.

NVIDIA RTX 6000 Ada (PCIe)

کارت RTX 6000 Ada با معماری Ada Lovelace و حافظه GDDR6 ECC بیشتر برای ورکاستیشنهای حرفهای و سرورهای سازمانی با کاربردهای رندرینگ پیشرفته، شبیهسازی و AI سبک طراحی شده است. این کارت با توان حرارتی متوسط و پشتیبانی PCIe Gen4 برای سازمانهایی که به دنبال ترکیبی از قدرت گرافیکی بالا و انعطافپذیری هستند، مناسب است. سرورهای HPE ProLiant DL380 Gen10 Plus و DL325 Gen10 Plus بستر مناسبی برای این کارت فراهم میکنند.

کاربرد اصلی این کارت در پروژههای ترکیبی گرافیکی و AI است که نیازمند عملکرد بالا در رندرینگ، طراحی صنعتی، و محاسبات موازی سبک هستند. برای استنتاج مدلهای AI متوسط و تسریع پردازشهای گرافیکی در محیطهای سازمانی، این کارت انتخابی مقرون به صرفه و قدرتمند محسوب میشود.

بیشتر بخوانید <<>> هوش مصنوعی در شبکه

معرفی سرورهای HPE پشتیبان کارتهای NVIDIA A100، H100 و RTX 6000 Ada

HPE Apollo 6500 Gen10 Plus

پشتیبانی از کارتها: NVIDIA A100 (SXM و PCIe)

ویژگیها:

- طراحی شده برای محاسبات سنگین هوش مصنوعی و یادگیری ماشین

- قابلیت نصب تا 8 کارت گرافیک A100 با اتصال NVLink برای مقیاسپذیری بالا

- سیستم خنککننده پیشرفته و منبع تغذیه قدرتمند مناسب برای توان حرارتی بالا (حدود 400 وات برای هر کارت)

- مناسب مراکز دادهای که نیاز به آموزش مدلهای بزرگ و محاسبات موازی گسترده دارند

HPE Apollo 6500 Gen11

پشتیبانی از کارتها: NVIDIA H100 (SXM)

ویژگیها:

- نسل جدید سرورهای HPE برای پشتیبانی از کارتهای نسل Hopper (H100)

- امکان نصب تعداد زیادی کارت H100 با پشتیبانی از NVSwitch و MIG

- طراحی بهینه شده برای مدیریت توان حرارتی بسیار بالا (حدود 700 وات برای هر کارت)

- مناسب پروژههای پیشرفته مولد AI و آموزش مدلهای بسیار بزرگ و سنگین

- بهبود یافته در زمینه تهویه، قدرت پردازشی و اتصالهای سریع بین کارتها

پشتیبانی از کارتها: NVIDIA RTX 6000 Ada (PCIe)

ویژگیها:

- سرور رکمونت دو یونیتی (2U) بسیار محبوب و متداول در دیتاسنترها و سازمانها

- پشتیبانی از کارتهای گرافیکی PCIe با توان حرارتی تا حدود 300 وات

- مناسب ورکلودهای ترکیبی، از جمله رندرینگ، محاسبات هوش مصنوعی سبک، و پردازشهای گرافیکی سازمانی

- قابلیت توسعه آسان و انعطافپذیری بالا در انتخاب سختافزار جانبی

پشتیبانی از کارتها: NVIDIA RTX 6000 Ada (PCIe)

ویژگیها:

- سرور تکپردازندهای (Single CPU) با کارایی بالا و طراحی فشرده

- مناسب برای سازمانهایی که نیاز به عملکرد گرافیکی قدرتمند با هزینه و مصرف انرژی کمتر دارند

- پشتیبانی از کارتهای PCIe نسل 4 و امکان بهرهبرداری از قابلیتهای RTX 6000 Ada

پشتیبانی از کارتها: NVIDIA A100، NVIDIA H100، NVIDIA RTX 6000 Ada (همگی در نسخه PCIe)

ویژگیها:

- سرور دو پردازندهای (Dual CPU) با قابلیت توسعهپذیری بالا، طراحیشده برای بارهای کاری سنگین در مقیاس سازمانی

- مناسب برای اجرای پروژههای پیچیده یادگیری عمیق، پردازش دادههای حجیم، مدلسازی پیشرفته و شبیهسازیهای علمی

- پشتیبانی کامل از کارتهای PCIe نسل 5، همراه با منابع تغذیه و خنککننده قدرتمند جهت استفاده از GPUهای قدرتمند مانند H100 و A100

- قابلیت نصب چندین کارت گرافیک بهصورت همزمان در پیکربندیهای خاص (با استفاده از GPU Enablement Kit و رایزرهای اختصاصی)

- انتخابی ایدهآل برای مراکز دادهای که به دنبال انعطافپذیری، عملکرد بالا و بهرهگیری حداکثری از قابلیتهای محاسباتی هوش مصنوعی هستند

چکلیست خرید کارت گرافیک AI برای مدیران و خریداران سرور HPE

تعیین نیازهای کاری و حجم پردازش

- چه نوع پروژههای AI قرار است اجرا شود؟ (آموزش مدلهای بزرگ، استنتاج، رندرینگ، شبیهسازی و…)

- میزان بار کاری و تعداد مدلهایی که همزمان اجرا خواهند شد.

- میزان نیاز به حافظه GPU (حافظه HBM یا GDDR6) و پهنای باند آن.

سازگاری با سرور

- اطمینان از سازگاری کارت با مدل سرور HPE موجود یا در نظر گرفته شده (مثلاً DL380 Gen11، Apollo 6500).

- بررسی نوع اسلات PCIe (نسل و تعداد) و پشتیبانی از کارتهای SXM یا PCIe.

- اطمینان از وجود فضای فیزیکی کافی برای نصب کارتها.

توان حرارتی و منبع تغذیه

- بررسی توان حرارتی (TDP) کارت و تطبیق آن با توان و ظرفیت خنککننده سرور.

- اطمینان از منبع تغذیه کافی و مناسب برای تامین برق کارتها، بهویژه اگر چند کارت در نظر گرفته شده است.

بودجه و هزینه کلی

- هزینه کارت گرافیک با توجه به بودجه سازمان.

- هزینههای جانبی مانند ارتقای منبع تغذیه، سیستم خنککننده، کابلها و نصب.

- هزینههای نگهداری و مصرف برق در طولانیمدت.

پشتیبانی و خدمات پس از فروش

- بررسی تضمین و گارانتی رسمی کارت گرافیک و سرور.

- دسترسی به خدمات پشتیبانی فنی و بهروزرسانیهای نرمافزاری.

- بررسی تجربه و نظرات سایر کاربران سازمانی و دیتاسنترها.

سازگاری نرمافزاری و درایورها

- اطمینان از پشتیبانی سیستمعامل و نرمافزارهای AI مورد استفاده.

- وجود درایورهای بهروز و ابزارهای مدیریت GPU.

- قابلیت بهرهبرداری از فناوریهای اختصاصی NVIDIA مثل NVLink، MIG، CUDA و Tensor Core.

افق توسعه و مقیاسپذیری

- امکان نصب چند کارت گرافیک در آینده برای افزایش توان پردازشی.

- قابلیت بهروزرسانی سختافزاری بدون تغییر کامل زیرساخت سرور.

ملاحظات فیزیکی و محیط عملیاتی

- دمای محیط و نیاز به سیستمهای خنککننده پیشرفته.

- محدودیتهای فضا در رک یا اتاق سرور.

- نویز و مصرف برق کارت در محیط کاری.

نکته پایانی:

برای بهترین انتخاب، توصیه میشود قبل از خرید، با تیم فنی HPE یا مشاوران متخصص مشورت کنید تا کانفیگ نهایی بر اساس نیازهای دقیق شما تنظیم شود.

بیشتر بخوانید <<>> بررسی هوش مصنوعی Chat GPT 4.5

سوالات متداول درباره کارتهای گرافیک AI در سرورهای HPE

1. کارتهای گرافیک NVIDIA A100، H100 و RTX 6000 Ada چه تفاوتهایی دارند؟

کارتهای A100 و H100 مخصوص محاسبات هوش مصنوعی سنگین و آموزش مدلهای بزرگ طراحی شدهاند، با این تفاوت که H100 نسل جدیدتر و قویتری است. RTX 6000 Ada بیشتر برای کاربردهای ترکیبی AI سبک و پردازش گرافیکی پیشرفته در سازمانها مناسب است.

2. آیا تمام سرورهای HPE از این کارتها پشتیبانی میکنند؟

خیر، فقط سرورهای خاصی مانند سری Apollo 6500 Gen10/11 و ProLiant DL380 Gen10/11 و DL325 Gen10/11 که مشخصات فنی لازم را دارند، از این کارتها پشتیبانی میکنند.

3. آیا نصب کارتهای گرافیک AI نیاز به ارتقای منبع تغذیه دارد؟

بله، کارتهای گرافیک AI مخصوصاً A100 و H100 مصرف برق بالایی دارند و ممکن است نیاز به منبع تغذیه قویتر و افزونه (Redundant PSU) باشد.

4. چه نوع خنککنندهای برای این کارتها لازم است؟

کارتهای A100 معمولاً با خنککننده هوا خنک میشوند اما در سرورهای با چند کارت، خنککننده مایع توصیه میشود. کارت H100 معمولاً نیاز به خنککننده مایع دارد. RTX 6000 Ada با خنککننده هوا به خوبی کار میکند.

5. آیا کارتهای SXM با PCIe تفاوت دارند؟

بله، کارتهای SXM از نظر طراحی و اتصال، امکان بهرهبرداری از NVLink با پهنای باند بسیار بالا را دارند که در کارتهای PCIe وجود ندارد. این موضوع در عملکرد بسیار سنگین AI تاثیرگذار است.

6. آیا میتوان چند کارت گرافیک را همزمان در یک سرور نصب کرد؟

بله، سرورهای HPE Apollo 6500 و برخی مدلهای ProLiant توانایی نصب چند کارت را دارند، اما باید به محدودیتهای توان حرارتی، برق و فضای فیزیکی توجه کرد.

7. چه سیستمعاملی برای استفاده از این کارتها مناسب است؟

سیستمعاملهای لینوکس (به ویژه توزیعهای محبوب در حوزه AI مانند Ubuntu و CentOS) و ویندوز سرور هر دو پشتیبانی میشوند، اما اکثراً لینوکس برای محاسبات AI ترجیح داده میشود.

8. آیا کارتهای NVIDIA برای یادگیری عمیق به نرمافزار خاصی نیاز دارند؟

بله، استفاده از CUDA Toolkit، cuDNN و فریمورکهای AI مانند TensorFlow، PyTorch، MXNet و… برای بهرهبرداری کامل از قدرت کارتها ضروری است.

9. چه نکاتی برای نگهداری و سلامت کارتهای گرافیک وجود دارد؟

نظارت بر دما و توان مصرفی، بهروزرسانی مرتب درایورها و Firmware، جلوگیری از نوسانات برق با استفاده از UPS و کنترل محیط خنکسازی از مهمترین نکات است.

آنچه در این مقاله بررسی شد

کارتهای گرافیک هوش مصنوعی مانند NVIDIA A100، H100 و RTX 6000 Ada نقش کلیدی در بهبود عملکرد محاسباتی و پردازشهای پیچیده هوش مصنوعی در سرورهای HPE ایفا میکنند. انتخاب درست این کارتها، متناسب با نیازهای کاری، ظرفیت سرور HP و بودجه سازمان، میتواند به طور قابل توجهی سرعت پردازش، دقت مدلها و بهرهوری کلی را افزایش دهد.

سرورهای HPE با پشتیبانی از این کارتهای پیشرفته و امکانات مدیریتی قوی، زیرساخت مناسبی برای استقرار راهکارهای هوش مصنوعی فراهم میآورند. توجه به نکات فنی در نصب، راهاندازی و نگهداری کارتها، از اهمیت ویژهای برخوردار است تا عملکرد پایدار و طول عمر مفید تجهیزات تضمین شود.

با برنامهریزی دقیق، بررسی سازگاری سختافزاری و نرمافزاری و انتخاب مدلهای متناسب، سازمانها میتوانند گامهای مؤثری در مسیر تحول دیجیتال و بهرهگیری از فناوریهای نوین هوش مصنوعی بردارند.

در نهایت، توصیه میشود پیش از خرید و نصب کارتهای گرافیک هوش مصنوعی، با کارشناسان فنی HPE و متخصصان حوزه AI مشورت شود تا بهترین راهکار متناسب با شرایط خاص سازمان انتخاب و پیادهسازی گردد.